NVIDIA H100 NVL

Hopper Architecture

Securely Accelerate Workloads From Enterprise to Exascale

- 96GB HBM3 Memory

- MPC 350w-400w

NVIDIA H100 NVL は、NVLinkブリッジで接続された 2基の合計 188GB HBM3メモリ、帯域幅計 7.8TB/sを実現し、H100 NVL GPUを搭載したサーバでは、GPT-175Bモデルの性能を NVIDIA DGX A100システムの最大 12倍まで向上します。

製品仕様

| H100 SXM | H100 PCIe | H100 NVL※1 x2 + NVLink Bridge |

|

| FP64 | 34 TFLOPS | 26 TFLOPS | 68 TFLOPS |

| FP64 Tensor コア | 67 TFLOPS | 51 TFLOPS | 134 TFLOPS |

| FP32 | 67 TFLOPS | 51 TFLOPS | 134 TFLOPS |

| TF32 Tensor コア | 989 TFLOPS※2 | 756 TFLOPS※2 | 1,979 TFLOPS※2 |

| BFLOAT16 Tensor コア | 1,979 TFLOPS※2 | 1,513 TFLOPS※2 | 3,958TFLOPS※2 |

| FP16 Tensor コア | 1,979 TFLOPS※2 | 1,513 TFLOPS※2 | 3,958 TFLOPS※2 |

| FP8 Tensor コア | 3,958 TFLOPS | 3,026 TFLOPS | 7,916 TFLOPS※2 |

| INT8 Tensor コア | 3,958 TOPS※2 | 3,026 TOPS※2 | 7,916 TOPS※2 |

| GPU メモリ | 80GB | 80GB | 188GB |

| GPU メモリ帯域幅 | 3.35TB/秒 | 2TB/秒 | 7.8TB/秒※3 |

| デコーダー | 7 NVDEC 7 JPEG |

7 NVDEC 7 JPEG |

14 NVDEC 14 JPEG |

| 最大熱設計電力 | 最大 700W (構成可能) |

300-350W (構成可能) |

2x 350-400W (構成可能) |

| マルチインスタンス GPU | 各 10GB 最大 7 MIG |

各 10GB 最大 7 MIG |

各 12GB 最大 14 MIG |

| フォーム ファクター | SXM | PCIe デュアルスロット 空冷 |

2x PCIe デュアルスロット 空冷 |

| 相互接続 | NVLink:900GB/秒 PCIe Gen5:128GB/秒 |

NVLink:600GB/秒 PCIe Gen5:128GB/秒 |

NVLink:600GB/秒 PCIe Gen5:128GB/秒 |

| NVIDIA AI Enterprise | アドオン | 含む | 含む |

参考仕様。仕様は変更される場合があります。

With sparsity

HBM 帯域幅の総計

Enterprise-Ready Utilization

管理者はリソースの利用率(ピークと平均の両方)を最大化することを目指しています。多くの場合、コンピューティングを動的に再構成し、使用中のワークロードに合わせてリソースを正しいサイズに変更します。

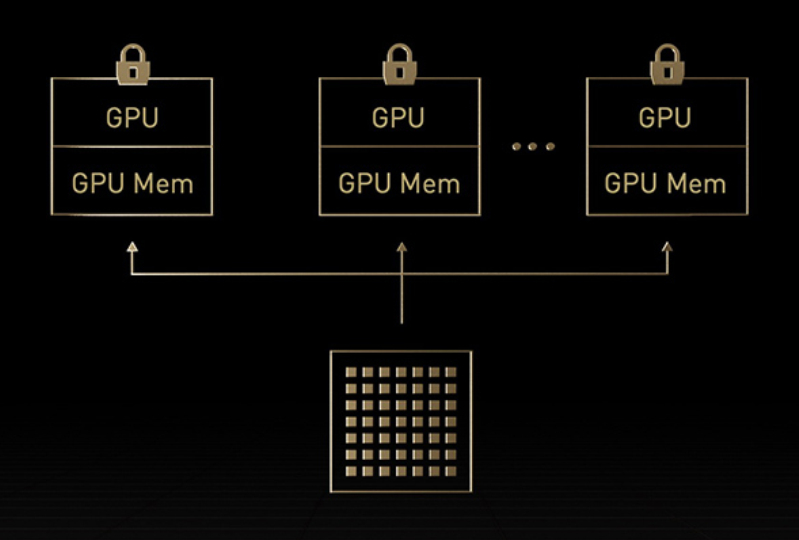

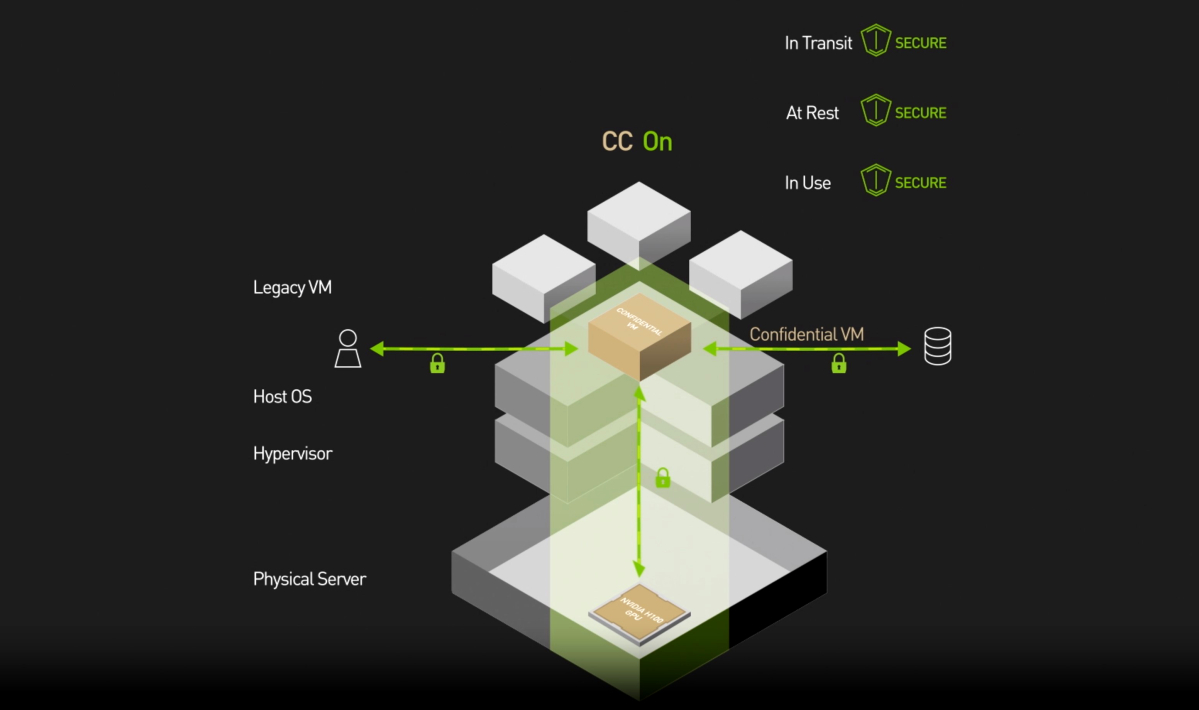

H100の第 2世代 MIGでは、7個ものインスタンスに分割することで各 GPUの利用率を最大化します。コンフィデンシャル コンピューティング対応の H100 では、マルチテナントをエンドツーエンドで安全に利用できます。クラウド サービス プロバイダー (CSP) 環境に最適です。

H100 と MIG なら、インフラストラクチャ管理者は GPU アクセラレーテッド インフラストラクチャを標準化できて、同時に、GPU リソースを非常に細かくプロビジョニングできます。正しい量のアクセラレーテッド コンピューティングが安全に開発者に与えられ、GPU リソースの利用を最適化します。

NVIDIA H100 の MIG

H100 は MIGの機能を強化しています。最大 7個の GPUインスタンスで仮想環境のマルチテナント/マルチユーザー構成をサポートします。コンフィデンシャルコンピューティングによってハードウェアおよびハイパーバイザーレベルで各インスタンスが分離されるため安全です。

MIGインスタンスごとに専用のビデオデコーダーが与えられ、共有インフラストラクチャで安定したハイスループットのインテリジェントビデオ解析(IVA)が実現します。

同時実行 MIGプロファイリングを利用すると、管理者はユーザーのために正しいサイズの GPU高速化を監視し、リソースを複数のユーザーに割り当てることができます。

研究者のワークロードが比較的少ない場合、完全なクラウド インスタンスを借りる代わりに、MIGを利用して GPUの一部を安全に分離することを選択できます。

保存中、移動中、使用中のデータが安全なため、安心です。

MIG の仕様

| H100 | A100 | |

| コンフィデンシャル コンピューティング |

対応 | – |

| インスタンスの種類 | 7x 10GB 4x 20GB 2x 40GB (より多くの計算処理能力) 1x 80GB |

7x 10GB 3x 20GB 2x 40GB 1x 80GB |

| GPU のプロファイリングと監視 | すべてのインスタンスで同時実行 | インスタンスは一度に 1 つだけ |

| テナントの保護 | 7x | 1x |

| メディア デコーダー | インスタンスあたりの 専用 NVJPEG と NVDEC |

限定オプション |

仕様は変更される場合があります。

NVIDIA コンフィデンシャルコンピューティング

使用中の AI ワークロードの機密性と完全性の保護

データや AIモデル、アプリケーションの使用時は、オンプレミスやクラウド等のいずれに展開されていても、外部からの攻撃や内部の脅威に対し脆弱となります。NVIDIA Hopperアーキテクチャで導入された画期的なセキュリティ機能である NVIDIA コンフィデンシャルコンピューティングは、AIワークロード向けの NVIDIA H100 Tensor コア GPU のかつてない高速化をユーザーに利用させながらそのような脅威を軽減します。強力なハードウェアベースのセキュリティを利用し、不正アクセスから機密データや専有の AIモデルを保護します。

NVIDIA H100 データシート

弊社では、科学技術計算や解析などの各種アプリケーションについて動作検証を行い、

すべてのセットアップをおこなっております。

お客様が必要とされる環境にあわせた最適なシステム構成をご提案いたします。