NVIDIA H200 PCIe 141GB NVL

AI Acceleration for Mainstream Enterprise Servers

- 141GB HBM3e Memory

- MPC 600W

NVIDIA H200 PCIe 141GB NVLは HBM3eメモリを 141GB搭載し最大 4つの GPUを NVIDIA NVLinkで接続することができ、コンピュータービジョンや音声 AI、RAG(検索拡張生成)などの実稼働向け生成AIソリューションの開発と展開を加速します。

前世代の H100 NVLと比較して大規模言語モデル (LLM) 推論は最大 1.7倍高速化し、HPCアプリケーションは最大 1.3倍のパフォーマンスを実現します。また、5年間のサブスクリプションが付属している NVIDIA AI Enterpriseには、生成AI展開を促進する NVIDIA NIMという使いやすいマイクロサービスセットが含まれており、エンタープライズ向けのセキュリティや管理性、安定性、サポートが提供されます。これにより、最適化されたAIソリューションを通じて、ビジネス価値と実用的な洞察を迅速に得ることが可能になります。搭載するサーバや納期等、導入ご検討の際はお気軽にお問い合わせください。

製品仕様

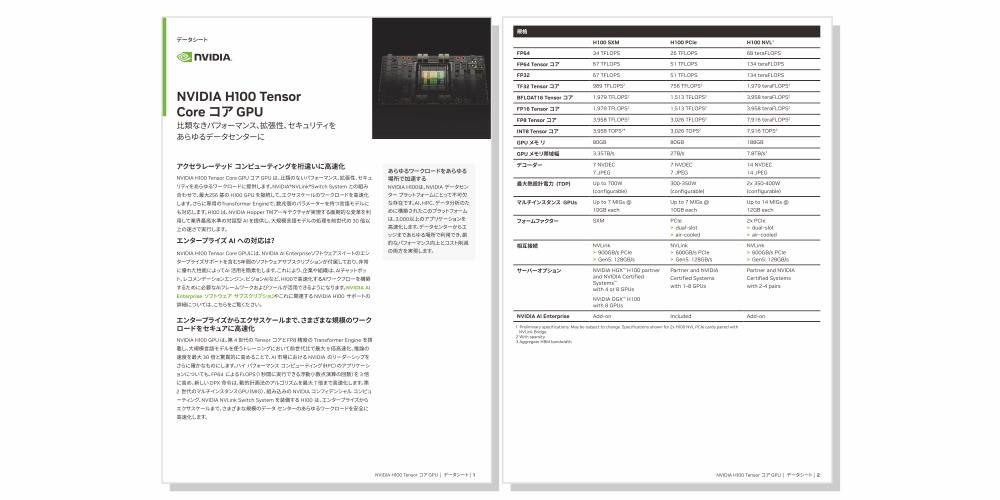

| H200 SXM | H200 NVL | |

| FP64 | 34 TFLOPS | 30 TFLOPS |

| FP64 Tensor コア | 67 TFLOPS | 60 TFLOPS |

| FP32 | 67 TFLOPS | 60 TFLOPS |

| TF32 Tensor コア | 989 TFLOPS※2 | 835 TFLOPS※2 |

| BFLOAT16 Tensor コア | 1,979 TFLOPS※2 | 1,671 TFLOPS※2 |

| FP16 Tensor コア | 1,979 TFLOPS※2 | 1,671 TFLOPS※2 |

| FP8 Tensor コア | 3,958 TFLOPS | 3,341 TFLOPS |

| INT8 Tensor コア | 3,958 TOPS※2 | 3,341 TOPS※2 |

| GPU メモリ | 141GB | 141GB |

| GPU メモリ帯域幅 | 4.8TB/秒 | 4.8TB/秒 |

| デコーダー | 7 NVDEC 7 JPEG |

7 NVDEC 7 JPEG |

| 最大熱設計電力 | 最大 700W (構成可能) |

最大 600W (構成可能) |

| マルチインスタンス GPU | 各18GB 最大7個のMIG |

各16.5GB 最大7個のMIG |

| フォーム ファクター | SXM | PCIe |

| 相互接続 | NVLink:900GB/秒 PCIe Gen5:128GB/秒 |

2ウェイまたは4ウェイの NVIDIA NVLink ブリッジ 900GB/秒 PCIe Gen5: 128GB/秒 |

| サーバオプション | GPUを4基または8基搭載の NVIDIA HGX H100 Partner および NVIDIA-Certified Systems |

GPUを4基または8基搭載の NVIDIA HGX H200 Partner および NVIDIA-Certified Systems |

| NVIDIA AI Enterprise | Add-on | Included |

参考仕様。仕様は変更される場合があります。

With sparsity

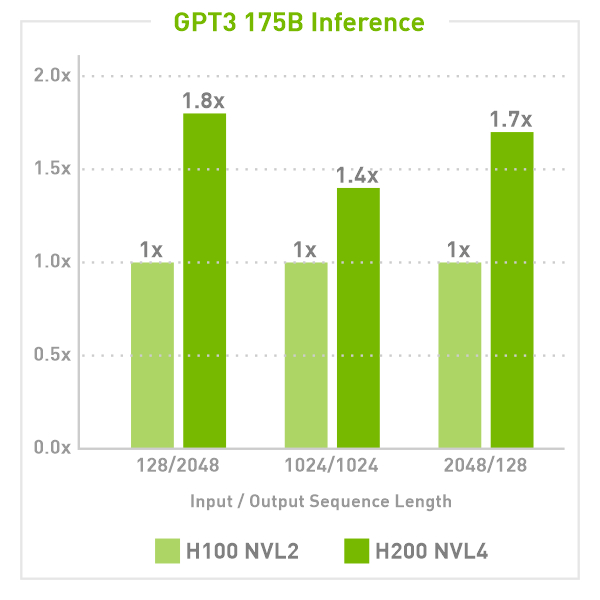

NVIDIA H200 NVL が 1.8 倍の推論パフォーマンスを実現

Preliminary performance, subject to change

LLAMA2 70B Inference, Max 1st token latency 1 sec

GPT3 175B Inference, FP8, Max 1st token latency 2 sec

All scenario based on following settings: 1)128 ISL/2K OSL; 2) 1K ISL/1K OSL; 3) 2K ISL / 128 OSL

FP8 for H100 NVL and H200 NVL

2-Way and 4-Way NVLink Bridges

2種類の NVLink Bridge

NVIDIA H200 Tensor Core GPU

弊社では、科学技術計算や解析などの各種アプリケーションについて動作検証を行い、

すべてのセットアップをおこなっております。

お客様が必要とされる環境にあわせた最適なシステム構成をご提案いたします。